VLA算法 X-VLA: Soft-Prompted Transformer as Scalable Cross-Embodiment Vision-Language-Action Model 论文解读

前言

XVLA这篇论文主要干了两件事:

- 提出了 soft-prompt 这个提升模型跨本体能力的架构设计(事实上并没有给予模型直接跨本体的能力,而是给予模型可以通过一小批数据的训练跨本体的能力,这里的区别之后会讲)

- 训练了一个采用 soft-prompt 架构 并且 采用了一系列其他技巧训练而成的基座vla模型 XVLA。

soft-prompt的架构是十分巧妙的,显然的有着其意义。

XVLA模型是小巧(0.9B)且强大的,显然的也有着其意义。

soft-prompt

问题定义

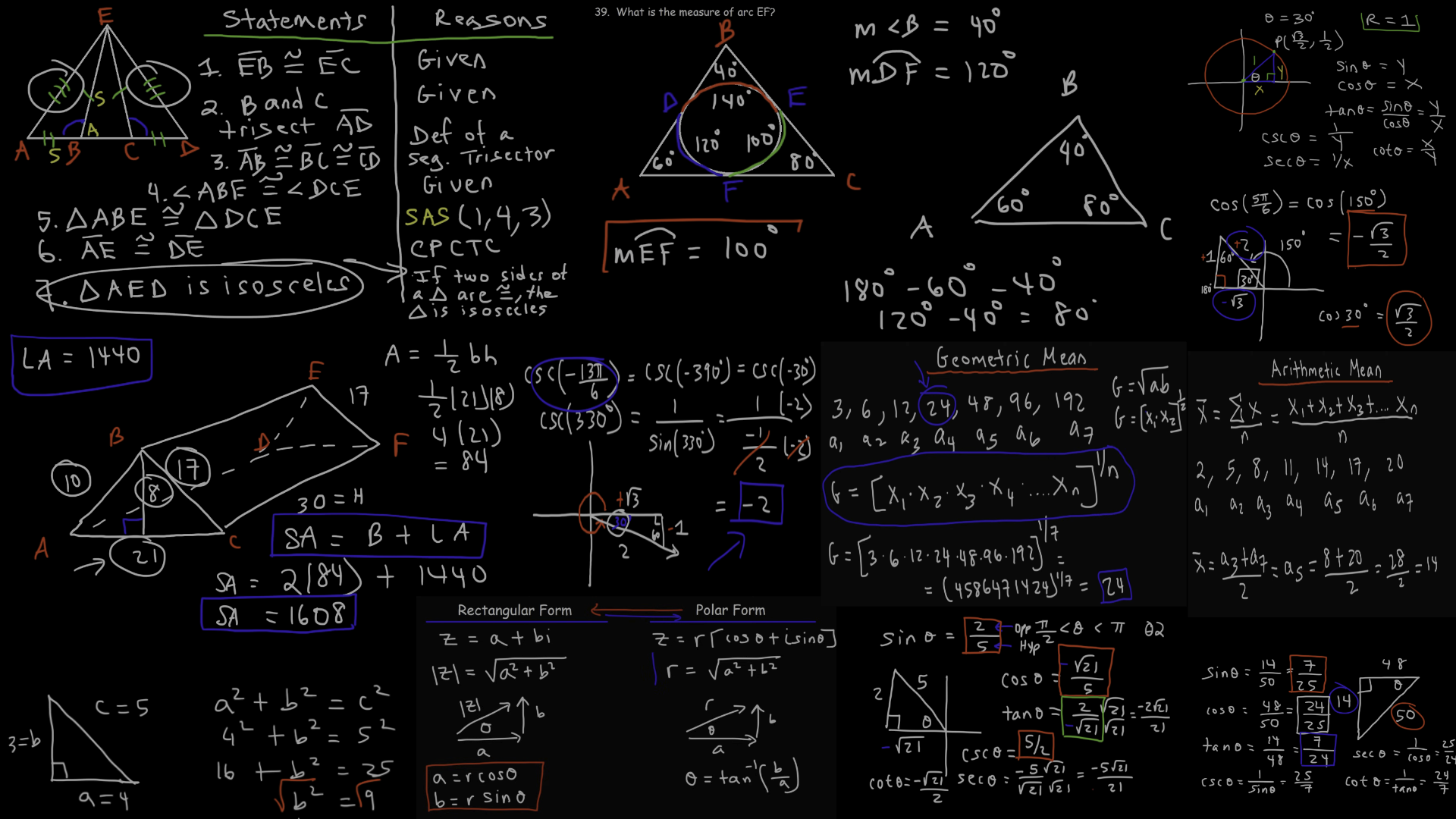

模型的实地部署效果和训练场景的效果相差较大一直是一个大问题。

这不止是因为部署时的背景环境的差别,更多的其实是因为部署时硬件配置和训练场景时的硬件配置不一样。

不同的硬件品牌,不同的两臂距离,不同的摄像头设置都会加剧这种问题。

使用具有跨本体效果的EEF并不能完全解决这个问题。(存疑)

架构解释

要完全解决这种因为硬件配置导致的效果下滑有很多种方式,但是主旨都是一样的,那就是将通用的知识和硬件配置特定的知识分开来进行存储。

文中也列出了符合这个主旨的解决方法的尝试,如下图。

论文图二

其中第一种方法是已经被人提出的:在action token最后的映射层根据不同硬件配置检索不同参数。

但是其有着很大的缺陷,也就是硬件配置相关的信息只能在动作生成的最后一步起作用,这让前期的大量的注意力计算根本意识不到硬件配置的更换。

作者指出了这一缺点,并提出了三种可能弥补这一缺陷的方法。

第二种方法是额外将观察token(语言图像)和vlabackbone之间的mlp设置为可以根据硬件替换的。

显然的是这对于vla输入的隐空间造成了极大且频繁的变动,对于训练稳定性是很不利的。

第三种方法通过自然语言描述来嵌入配置信息,但是显然的是配置信息很难通过简洁的语言表示。

通过下面表格的例子可以看出。

论文表十

第四种方法就是如下的方法,同时作者还做出了一些改动。

soft-prompt的架构非常的简单,直接看下面的架构图就可以看明白。

论文图十

如果是为了了解soft-prompt的结构的话,我们只看虚线以上的部分就够了,如下。

训练时根据不同数据集(实际上就是不同的硬件配置,哪怕相同的机械臂搭建的时候也会存在不同那显然也视为不同的硬件配置)的id选取不同的soft-prompt,input/output projection,这样迫使模型将通用的信息压缩到公用的部分,把配置信息压缩到soft-prompt,input/output projection中。

对于上面的三种方案,作者做了训练阶段的对比实验,如图。

论文图四

实验证明了方法四的优越性,但是我仍然觉得应该用实测代替评估损失。

除了上面被毙掉的两个方案(方案二和三),作者还对两个很有希望的方案进行了实验。

也就是

- 框架不变,预训练时采用lora更新主体架构。

- 引入moe,期望模型自动在不同expert分配不同硬件信息。

事实上两种方法都遇到了训练问题。

第一种方法在直觉上就不可能成功,因为它无法强制backbone习得通用的知识,很可能出现附加层学会大部分知识的情况。况且,在预训练阶段backbone不稳定的情况下引入lora附加层很容易训练崩掉。

第二种方法作者遇到了moe训练普遍遇到的路由只选特定专家的问题,尝试加入正则但是训练不稳定。

训练

回到soft-prompt架构

这样的一个架构我们要如何训练它呢?

在预训练的过程中,就如上一节提到的,给每个数据集分配一个id,根据id动态选择参数进行训练。

而在预训练完之后,对于新的硬件配置,我们分两个阶段完成微调。

- 冻结除了soft-prompt,input/output projection之外的所有参数,进行微调。

- 所有参数进行微调。

这个两阶段的划分十分容易理解且符合直觉,但作者仍然做了训练recipe的消融,这是值得肯定的。

论文图九

(这里有一个有意思的观点的迂回,不同的初始化影响的不只是收敛的速度,还有最终的收敛值)

可能的改进

论文提出的soft-prompt方案十分有力,可以想象这个架构在未来也会一直起着作用。

论文描述了这样一个未来:对于任何一个新的硬件配置,只需要很少的数据就可以让模型在保留原有能力的同时适应这个硬件配置。

但是我觉得论文仍然可以增加一个实验:模型A通过两阶段微调适应了硬件a,于此同时训练出了一个硬件啊对应的硬件知识插件。

直接将硬件a对应的插件替换给模型B,模型B不需要训练也适应了硬件a。

这其实在证明一件事:模型对于硬件配置的适应性和其通用能力进行了彻底的解耦。

这满足了具身领域算法和硬件的前后向兼容。

这种兼容的需求是 算法/硬件不断迭代的同时,一定会人为制造/自然形成算法硬件版本错配 造成的。

XVLA

论文的另一个成果就是加上了soft-prompt技术的新基座模型xvla。

论文对于xvla的架构设计以及训练recipe选择进行了详尽的介绍,下表就是一个技术选择的消融结果(所有提到的技术都使用的情况下把每个技术都单独除去后比较效果是更好的选择)

论文表一

其中的 Intension abstraction比较有意思,这个技巧实际上是降低收集数据时的视频帧率的优化版。

如何在降低数据帧率的同时做到删去的帧数据都是无效的呢?这是一个有趣的点。

编排的问题

论文给出了两个新东西。

但是这两者在一篇文章中出现却给我的阅读带来了很多的障碍,最明显的是:

- 读者的预期是错位的。我期望得到一个对于新技术的明了的介绍,但是论文夹杂着大量的关于如何训练一个基座vla模型的技巧的介绍。

- 对比是不公平的。soft-prompt架构的有效性!=使用了soft-prompt架构以及其他一系列架构/训练recipe创新的xvla的有效性。论文的对比实验使用的xvla,显然不具有很强的说服力

附上benchmark表现对比。

论文表二